Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | |||||

| 3 | 4 | 5 | 6 | 7 | 8 | 9 |

| 10 | 11 | 12 | 13 | 14 | 15 | 16 |

| 17 | 18 | 19 | 20 | 21 | 22 | 23 |

| 24 | 25 | 26 | 27 | 28 | 29 | 30 |

Tags

- 데이터시각화

- String Method

- 가상환경

- 알고리즘

- 백준

- Matplotlib

- 노마드코딩

- Algorithm

- pandas

- queue

- 알고리즘 스터디

- Stack

- aws jupyter notebook

- NumPy

- Selenium

- 파이썬

- 프로그래머스

- programmers

- javascript

- 정보처리기사 c언어

- 선그래프

- openCV

- 자료구조

- 알고리즘스터디

- python

- type hint

- dataframe

- 코딩테스트

- Join

- MySQL

Archives

- Today

- Total

목록DeepLearning (1)

조금씩 꾸준히 완성을 향해

[DeepLearning] 활성화 함수(Activation Function) +코드 구현 (Sigmoid, ReLU, LeakyReLu, Elu, tanh, Softmax 등)

[DeepLearning] 활성화 함수(Activation Function) +코드 구현 (Sigmoid, ReLU, LeakyReLu, Elu, tanh, Softmax 등)

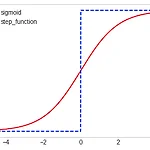

활성화 함수(Activation Function) 입력 신호의 총합을 출력 신호로 변환하는 함수 활성화 함수에 따라 출력값이 결정 단층, 다층 퍼셉트론 모두 사용 대표적인 활성화 함수 Sigmoid ReLU tanh Identity Function Softmax 하나의 layer에서 다음 layer로 넘어갈 때는 항상 활성화 함수를 통과 [참고] 여러가지 활성화 함수 https://en.wikipedia.org/wiki/Activation_function Step Function(계단 함수) def step_func(x): if x > 0 : return 1 else: return 0 def step_func_for_numpy(x): y = x > 0 return y.astype(np.int) print..

AI/Deep Learning

2022. 11. 13. 19:11